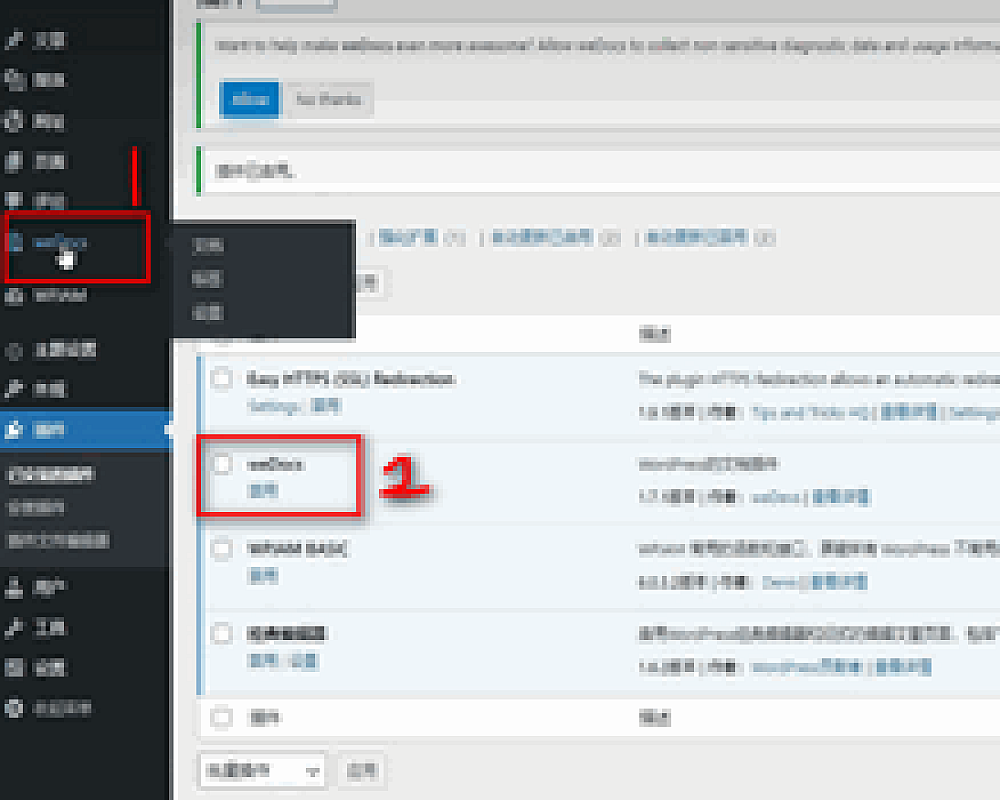

WordPress网站的Robots文件应该怎么写

什么是Robots文件以及它的作用是什么。robots文件简单的来说就是给你的网站做一个权限清单,一般是针对做SEO优化的。在这个文件里面写上哪些文件、哪些形式的链接允许搜索引擎抓取,哪些不允许。

User-agent: *

Disallow:/*?*

下面分享一下Wordpress网站Robots文件正常写法。

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-content/

Disallow: /wp-includes/

Disallow: /*/comment-page-*

Disallow: /*?replytocom=*

Disallow: /category/*/page/

Disallow: /tag/*/page/

Disallow: /*/trackback

Disallow: /feed

Disallow: /*/feed

Disallow: /comments/feed

Disallow: /?s=*

Disallow: /*/?s=*\

Disallow: /*?*

Disallow: /attachment/

代码详解:

1、Disallow: /wp-admin/、Disallow: /wp-content/和Disallow: /wp-includes/

用于告诉搜索引擎不要抓取后台程序文件页面。

2、Disallow: //comment-page-和Disallow: /?replytocom=

禁止搜索引擎抓取评论分页等相关链接。

3、Disallow: /category//page/和Disallow: /tag//page/

禁止搜索引擎抓取收录分类和标签的分页。

4、Disallow: /*/trackback

禁止搜索引擎抓取收录trackback等垃圾信息

5、Disallow: /feed、Disallow: /*/feed和Disallow: /comments/feed

禁止搜索引擎抓取收录feed链接,feed只用于订阅本站,与搜索引擎无关。

6、Disallow: /?s=和Disallow: //?s=*\

禁止搜索引擎抓取站内搜索结果

7、Disallow: /?

禁止搜索抓取动态页面

8、Disallow: /attachment/

禁止搜索引擎抓取附件页面,比如毫无意义的图片附件页面。